Si vous exploitez un site web, vous avez probablement entendu parler du fichier robots.txt. Ce fichier est crucial car il aide les moteurs de recherche à comprendre quelles sont les pages qu’ils sont autorisés à explorer et à indexer sur votre site web. Cependant, il peut être difficile de modifier et de maintenir correctement le fichier robots.txt. C’est là que l’outil de vérification du fichier robots.txt s’avère utile ! Dans cet article de blog, nous verrons ce qu’est un outil de vérification robots.txt, pourquoi il est essentiel pour votre site web et comment vous pouvez l’utiliser efficacement. C’est parti !

1. L’Importance De Robots.txt Pour Le Référencement De Votre Site Web

Le fichier robots.txt est un élément essentiel de tout site web, en particulier pour le référencement. Une analyse approfondie via une liste de contrôle d’audit SEO permet de s’assurer que ces fichiers sont configurés de manière optimale. En contrôlant les pages auxquelles les robots des moteurs de recherche peuvent accéder, les propriétaires de sites web peuvent protéger les informations importantes et donner la priorité à l’indexation des pages significatives. Toutefois, si un site web ne dispose pas d’un fichier robots.txt, Google peut toujours découvrir et indexer toutes les pages essentielles. Pour les stratèges et les développeurs SEO, l’utilisation du testeur Adsbot robots.txt peut être un outil utile pour gérer et comprendre la manière dont les robots d’indexation parcourent un site web. Dans l’ensemble, le fichier robots.txt est un aspect du référencement qu’il ne faut pas négliger. Adsbot vous aide à vérifier le fichier robots.txt, ce qui vous évitera de perdre du temps et de l’argent. Vous pouvez remarquer rapidement ce que vous devez faire pour des annonces bien optimisées.

2. Comprendre Comment Les Robots De Google Utilisent Robots.txt

Les robots d’exploration de Google utilisent le fichier robots.txt pour déterminer les pages de votre site web qu’ils peuvent explorer et indexer. L’intégration d’une liste de contrôle technique SEO rigoureuse permet de s’assurer que l’infrastructure du site est parfaitement lisible par ces agents. En spécifiant les pages à bloquer ou à autoriser dans votre fichier robots.txt, vous pouvez vous assurer que la visibilité de votre site web sur les moteurs de recherche reste optimisée. Il est important de comprendre que les robots des moteurs de recherche suivent les règles définies dans votre fichier robots.txt, mais cela ne garantit pas qu’ils les respecteront toujours. En outre, si vous bloquez accidentellement des pages importantes, cela peut avoir un impact négatif sur le référencement de votre site web. Il est essentiel de tester et de valider régulièrement votre fichier robots.txt pour vous assurer qu’il est correctement optimisé pour la visibilité dans les moteurs de recherche. Avec l’outil Adsbot robots.txt checker, vous pouvez vérifier le fichier robots.txt sur votre page pour gérer et comprendre comment les robots d’indexation explorent un site web. En suivant les meilleures pratiques avec l’outil de test Adsbot robots.txt et en évitant les erreurs courantes dans la rédaction de votre fichier robots.txt, vous pouvez gérer et contrôler efficacement l’accessibilité de votre site web aux robots d’indexation.

3. Utilisation De L’outil De Test Robots.txt Pour Vérifier Les Url Bloquées

L’outil de test d’Adsbot robots.txt est un outil essentiel pour les propriétaires de sites web qui veulent s’assurer qu’ils ont correctement bloqué les URL indésirables. Pour une maintenance complète, l’application d’une liste de contrôle pour l’audit du site web aide à identifier les ressources qui ne devraient pas être indexées. Comme nous l’avons vu précédemment, le fichier Adsbot robots.txt aide à gérer le trafic des robots d’indexation vers un site web, et l’outil de test robots.txt permet aux webmasters de vérifier si le fichier bloque ou autorise correctement l’accès aux URL. En saisissant simplement une URL bloquée ou autorisée dans l’outil de test, les webmasters peuvent rapidement déterminer si l’URL est accessible ou restreinte. Il est important de valider régulièrement le testeur Adsbot robots.txt pour s’assurer qu’il fonctionne correctement et qu’il ne cause pas de problèmes de référencement inutiles. Toutefois, il est tout aussi important de faire preuve de prudence lors du blocage d’URL, car le blocage excessif de pages importantes peut nuire au référencement d’un site web. La meilleure pratique consiste à surveiller et à ajuster régulièrement le testeur Adsbot robots.txt afin d’optimiser l’indexation du site web tout en évitant les pièges potentiels liés au blocage de pages critiques.

4. Comment Tester Et Valider Votre Fichier Robots.txt ?

Pour vous assurer que le fichier robots.txt de votre site bloque les robots indésirables tout en permettant aux moteurs de recherche d’explorer et d’indexer vos pages, il est essentiel de le tester et de le valider régulièrement. L’examen des éléments structurels via une liste de contrôle SEO sur la page complète idéalement cette étape technique. L’outil Adsbot robots.txt testing est un outil qui vous permet d’entrer l’URL de votre site web et de tester son fichier robots.txt. Adsbot vérifie si des URL et des ressources sont bloquées et vous aide à identifier la règle qui les bloque. En identifiant et en corrigeant ces problèmes, vous pouvez améliorer le référencement de votre site web et empêcher les moteurs de recherche d’indexer incorrectement le contenu. Il est recommandé de tester et de valider votre fichier robots.txt avec Adsbot checker après toute modification importante de votre site web afin de vous assurer qu’il continue à bien se classer dans les résultats de recherche.

5. Les Risques De Bloquer Des Pages Importantes Avec Robots.txt

Le blocage de pages importantes à l’aide d’un fichier robots.txt peut présenter des risques importants pour le référencement d’un site web. Bien qu’une URL interdite puisse toujours apparaître dans les résultats de recherche, elle n’aura pas de description, ce qui peut avoir un impact négatif sur le taux de clics. En outre, l’interdiction des URL signifie que Google ne peut pas explorer ces pages pour en déterminer le contenu. Il est crucial de surveiller les réponses du serveur car il faut comprendre qu’est-ce que le code d’état 3xx et savoir comment résoudre le code d’état 4xx pour maintenir une indexation saine. Il est important de ne pas interdire accidentellement des pages importantes, car cela peut avoir un impact significatif sur le trafic et la visibilité de votre site web. Il est donc essentiel de comprendre comment vérifier et valider correctement votre fichier robots.txt et d’éviter les erreurs courantes lors de sa rédaction. Adsbot est un logiciel d’optimisation PPC qui comprend également un service de test du fichier robots.txt. Grâce à une technologie parfaite d’apprentissage automatique, Adsbot aide votre compte à être bien analysé, amélioré et mis à jour en fonction des besoins des clients en temps réel. Une gestion et une surveillance appropriées du fichier robots.txt permettent de s’assurer que les moteurs de recherche peuvent explorer toutes les pages nécessaires. Vous pouvez facilement essayer Adsbot robots.txt checker pour voir comment il fonctionne pour votre entreprise !

6. Erreurs Courantes À Éviter Lors De La Rédaction De Votre Fichier Robots.txt

Plusieurs erreurs doivent être évitées lors de la création d’un fichier robots.txt. Une erreur typique est l’utilisation d’une syntaxe incorrecte, qui pourrait empêcher les robots des moteurs de recherche de voir les pages de votre site. Pour les boutiques en ligne, suivre une liste de contrôle SEO pour le commerce électronique ou une liste de contrôle SEO Shopify spécifique permet d’éviter les erreurs de configuration propres aux plateformes CMS. Il est important de noter que le simple fait d’interdire une page n’empêche que parfois les robots de l’explorer. En outre, un fichier robots.txt vide peut entraîner des problèmes d’exploration et d’indexation de votre site. Il est également important de veiller à ce que votre fichier robots.txt se trouve dans le répertoire racine de votre site. Lorsque vous disposez de l’outil Adsbot robots.txt checker, vous pouvez être sûr qu’Adsbot explore et indexe correctement votre site web. En évitant ces erreurs courantes et en testant et validant régulièrement votre fichier robots.txt, vous pouvez vous assurer que votre site est correctement exploré et indexé par les moteurs de recherche.

7. Comment Autoriser Ou Bloquer Des Agents Utilisateurs Spécifiques Avec Robots.txt

Pour autoriser ou bloquer des agents utilisateurs spécifiques à l’aide du fichier robots.txt, les propriétaires de sites web doivent comprendre la syntaxe du fichier. Chaque règle du fichier robots.txt bloque ou autorise l’accès de tous les robots ou d’un robot spécifique à un chemin d’accès spécifié sur le domaine ou le sous-domaine. Pour les entreprises de proximité, il est essentiel de définir qu’est-ce que le référencement local et d’appliquer une liste de contrôle du référencement local pour garantir que les bots accèdent aux pages de services locaux. Les propriétaires de sites web peuvent utiliser la directive « user-agent » pour nommer un robot spécifique et lui appliquer des règles. Des règles spécifiques peuvent être appliquées à certains agents utilisateurs, tandis que d’autres agents utilisateurs peuvent être autorisés à explorer l’ensemble du site. Il est important de noter que les robots d’exploration suivront les règles les plus spécifiques définies pour eux avec le nom spécifié dans la directive « user-agent ». Pour s’assurer que des agents utilisateurs spécifiques sont bloqués ou autorisés, les propriétaires de sites web devraient utiliser l’outil de test Adsbot robots.txt. Cet outil fonctionne comme Googlebot et valide que votre URL a été correctement bloquée ou autorisée sur la base des règles relatives aux agents utilisateurs définies dans le fichier robots.txt.

8. Comment Les Moteurs De Recherche Utilisent Robots.txt Pour Découvrir Votre Plan Du Site

Dans la section 8 du blog, nous continuons à explorer le rôle du fichier robots.txt dans le référencement des sites web. Cette fois, l’accent est mis sur la façon dont les moteurs de recherche utilisent ce fichier pour découvrir votre sitemap. Pour ceux qui ne sont pas familiers avec le sujet, un sitemap est un fichier qui répertorie toutes les pages, images et autres contenus pertinents de votre site web. Adsbot robots.txt checker vous montre comment vérifier les robots.txt des moteurs de recherche sur votre site web par crawling. En ayant un sitemap, vous facilitez la tâche des robots d’indexation des moteurs de recherche pour trouver et indexer vos pages. Toutefois, si vous bloquez le sitemap dans votre fichier robots.txt, les moteurs de recherche ne sauront pas qu’il existe. Dans cette section, les lecteurs apprendront comment permettre aux robots des moteurs de recherche d’accéder au sitemap dans le fichier robots.txt et pourquoi il est important pour la visibilité du site web. Comme toujours, le blog propose des conseils pratiques et des bonnes pratiques pour mettre en œuvre cette stratégie.

9. Comment Soumettre Manuellement À L’indexation Les Pages Bloquées Par Robots.txt ?

Après avoir identifié les pages bloquées dans la Search Console et corrigé les erreurs dans le fichier robots.txt avec Adsbot, il peut être nécessaire de soumettre manuellement ces pages à l’indexation. Cette opération peut être effectuée à l’aide de l’outil d’inspection des URL dans la Search Console. Lors d’un changement de structure, l’utilisation d’une liste de contrôle de la migration SEO ou d’une liste de contrôle du référencement international est indispensable pour coordonner la ré-indexation. Tout d’abord, sélectionnez l’URL bloquée et cliquez sur « Demander l’indexation » pour lancer la demande de crawl. Ce processus peut prendre plusieurs jours, mais une fois que la page est indexée, elle devrait apparaître dans les résultats de recherche. Il est donc important de s’assurer que le fichier robots.txt est correctement configuré pour éviter de bloquer inutilement les robots d’indexation. En suivant les meilleures pratiques avec Adsbot robots.txt checker pour gérer et surveiller le fichier robots.txt, les propriétaires de sites web peuvent optimiser leur site pour les moteurs de recherche tout en gardant le contrôle sur la façon dont le contenu est indexé et affiché aux utilisateurs.

Popular Posts

-

Vérificateur de robots.txt

Vérificateur de robots.txtSi vous exploitez un site web, vous avez probablement entendu…

Read more -

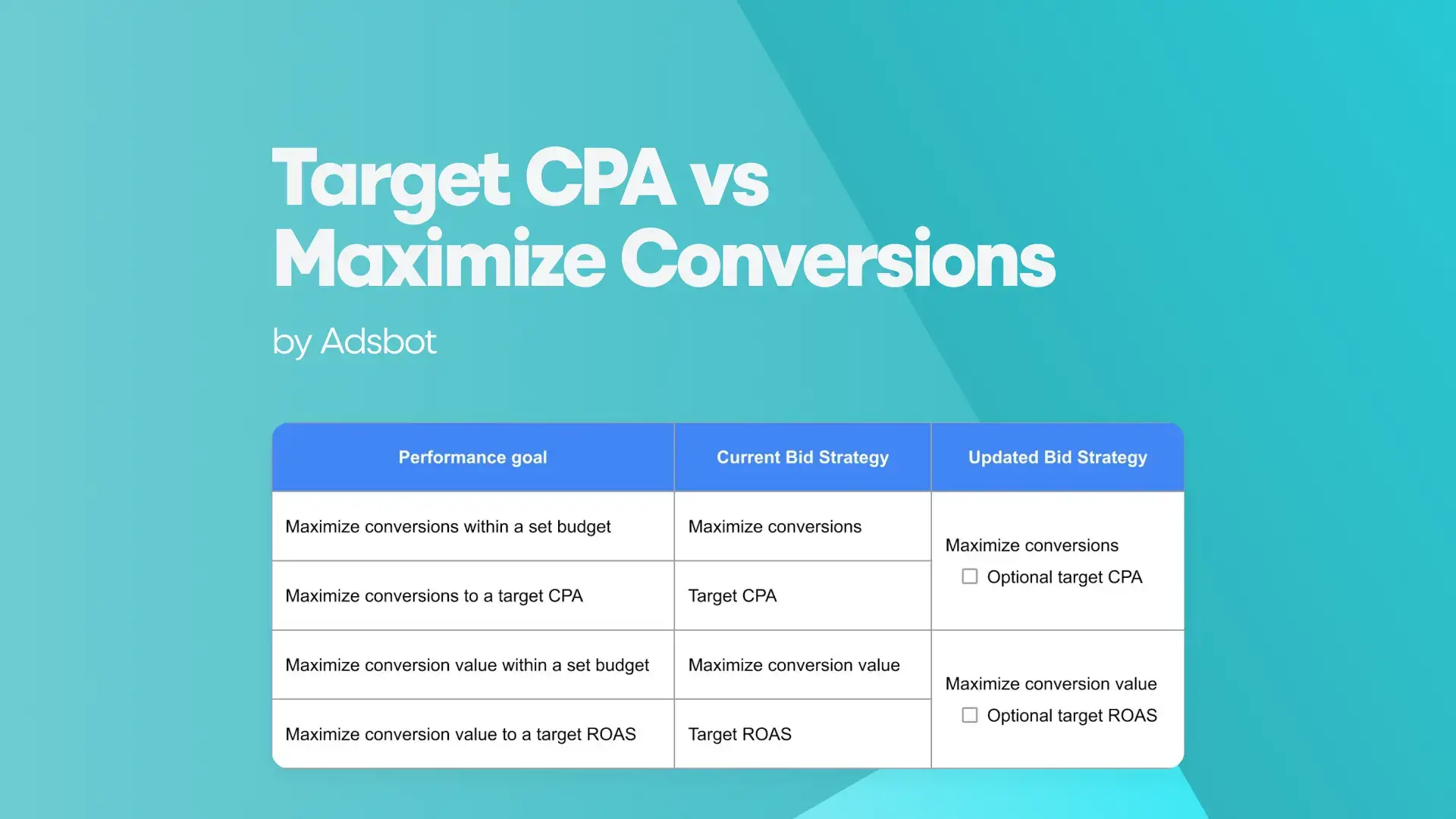

Cibler le CPA et maximiser les conversions

Afin d’obtenir les meilleurs résultats avec Google Ads, il est…

Read more -

Qu’est-ce que l’Ad Rank ?

Le classement des annonces est un indicateur utilisé par Google…

Read more -

Qu’est-ce que l’enchère de marque dans Google Ads ?

Qu’est-ce Que L’enchère De Marque Dans Google Ads ? Vous…

Read more

Register for our Free 14-day Trial now!

No credit card required, cancel anytime.