Wenn Sie eine Website betreiben, haben Sie wahrscheinlich schon von der robots.txt-Datei gehört. Diese Datei ist von entscheidender Bedeutung, denn sie hilft Suchmaschinen zu verstehen, welche Seiten sie auf Ihrer Website crawlen und indizieren dürfen. Es kann jedoch verwirrend und schwierig sein, die robots.txt-Datei korrekt zu bearbeiten und zu pflegen. Hier kommt das robots.txt-Checker-Tool ins Spiel! In diesem Blogbeitrag erfahren Sie, was ein robots.txt-Checker ist, warum er für Ihre Website wichtig ist und wie Sie ihn effektiv einsetzen können. Fangen wir also an!

1. Die Bedeutung Von Robots.txt Für Die Suchmaschinenoptimierung Ihrer Website

Die robots.txt-Datei ist ein wichtiger Bestandteil jeder Website, insbesondere für die Suchmaschinenoptimierung. Durch die Kontrolle, auf welche Seiten Suchmaschinen-Crawler zugreifen können, können Website-Besitzer wichtige Informationen schützen und die Indizierung wichtiger Seiten priorisieren. Verfügt eine Website jedoch nicht über eine robots.txt-Datei, kann Google in der Regel trotzdem alle wichtigen Seiten finden und indexieren. Für SEO-Strategen und -Entwickler kann der Adsbot robots.txt-Tester ein hilfreiches Tool sein, um zu verstehen, wie Webspider eine Website crawlen. Insgesamt ist die robots.txt-Datei ein Aspekt der SEO, der nicht übersehen werden sollte. Adsbot hilft Ihnen bei der Überprüfung der robots.txt, wodurch Sie Zeit- und Geldverschwendung vermeiden können. Sie können frühzeitig erkennen, was Sie für gut optimierte Anzeigen tun müssen.

2. Verstehen, Wie Google Web Crawler Die Robots.txt Verwenden

Google Webcrawler verwenden robots.txt, um zu bestimmen, welche Seiten Ihrer Website sie crawlen und indizieren können. Indem Sie in Ihrer robots.txt-Datei angeben, welche Seiten blockiert oder zugelassen werden sollen, können Sie sicherstellen, dass die Sichtbarkeit Ihrer Website in Suchmaschinen optimiert bleibt. Es ist wichtig zu wissen, dass Suchmaschinen-Bots die in Ihrer robots.txt-Datei festgelegten Regeln befolgen, aber es ist nicht garantiert, dass sie sich immer daran halten. Wenn Sie außerdem versehentlich wichtige Seiten blockieren, kann sich dies negativ auf die Suchmaschinenoptimierung Ihrer Website auswirken. Es ist wichtig, dass Sie Ihre robots.txt-Datei regelmäßig testen und validieren, um sicherzustellen, dass sie für die Sichtbarkeit in Suchmaschinen optimiert ist. Mit dem Adsbot robots.txt Checker-Tool können Sie die robots.txt-Datei auf Ihrer Seite überprüfen, um zu verstehen und zu verwalten, wie Webspider eine Website crawlen. Wenn Sie mit dem Adsbot robots.txt-Testtool bewährte Verfahren befolgen und häufige Fehler beim Schreiben Ihrer robots.txt-Datei vermeiden, können Sie die Zugänglichkeit Ihrer Website für Webcrawler effektiv verwalten und überwochen.

3. Verwendung Des Robots.txt-tester-tools Zur Überprüfung Gesperrter Urls

Das Adsbot robots.txt-Testtool ist ein unverzichtbares Werkzeug für Website-Betreiber, die sicherstellen möchten, dass sie unerwünschte URLs ordnungsgemäß blockiert haben. Wie bereits erwähnt, hilft die Adsbot robots.txt-Datei dabei, den Crawler-Verkehr auf einer Website zu steuern, und mit dem robots.txt-Testtool können Webmaster überprüfen, ob die Datei den Zugriff auf URLs korrekt blockiert oder erlaubt. Durch die einfache Eingabe einer gesperrten oder erlaubten URL in das Testtool können Webmaster schnell feststellen, ob die URL zugänglich oder eingeschränkt ist. Es ist wichtig, den Adsbot robots.txt Checker regelmäßig zu validieren, um sicherzustellen, dass er korrekt funktioniert und keine unnötigen SEO-Probleme verursacht. Es ist jedoch ebenso wichtig, bei der Sperrung von URLs vorsichtig zu sein, da eine übermäßige Sperrung wichtiger Seiten der SEO einer Website schaden kann. Am besten ist es, den Adsbot robots.txt-Tester konsequent zu überwachen und anzupassen, um die Crawlability der Website zu optimieren und gleichzeitig die potenziellen Fallstricke des Blockierens kritischer Seiten zu vermeiden.

4. Wie Sie Ihre Robots.txt-datei Testen Und Validieren

Um sicherzustellen, dass die robots.txt-Datei Ihrer Website unerwünschte Bots blockiert und es Suchmaschinen ermöglicht, Ihre Seiten zu crawlen und zu indizieren, ist es wichtig, sie regelmäßig zu testen und zu validieren. Adsbot robots.txt testing tool ist ein Tool, mit dem Sie die URL Ihrer Website eingeben und die robots.txt-Datei testen können. Adsbot prüft, ob URLs und Ressourcen blockiert sind, und hilft Ihnen, die Regel zu identifizieren, die sie blockiert. Wenn Sie diese Probleme erkennen und beheben, können Sie die Suchmaschinenoptimierung Ihrer Website verbessern und verhindern, dass Suchmaschinen Inhalte falsch indizieren. Es wird empfohlen, Ihre robots.txt-Datei nach wesentlichen Änderungen an Ihrer Website mit dem Adsbot-Checker zu testen und validieren, insbesondere bei komplexen Migrationen unter Verwendung unserer SEO-Migrationscheckliste, um sicherzustellen, dass Ihre Website weiterhin gut in den Suchergebnissen platziert wird.

5. Die Risiken Des Blockierens Wichtiger Seiten Mit Robots.txt

Das Blockieren wichtiger Seiten mit einer robots.txt-Datei kann erhebliche Risiken für die Suchmaschinenoptimierung einer Website mit sich bringen. Obwohl eine gesperrte URL immer noch in den Suchergebnissen erscheinen kann, hat sie keine Beschreibung, was sich negativ auf die Klickraten auswirken kann. Außerdem bedeutet das Verbot von URLs, dass Google diese Seiten nicht crawlen kann, um ihren Inhalt zu ermitteln, was dazu führen kann, dass sie aus den Suchergebnissen verschwinden. Es ist wichtig, dass Sie nicht versehentlich wichtige Seiten deaktivieren, da dies erhebliche Auswirkungen auf den Traffic und die Sichtbarkeit Ihrer Website haben kann. Daher ist es wichtig, dass Sie wissen, wie Sie Ihre robots.txt-Datei richtig überprüfen und validieren und häufige Fehler bei der Erstellung vermeiden. Adsbot ist eine PPC-Optimierungssoftware, die auch einen robots.txt-Testservice beinhaltet. Dank der perfekten Technologie des maschinellen Lernens hilft Adsbot, Ihr Konto gut zu analysieren, zu verbessern und entsprechend den Kundenbedürfnissen in Echtzeit zu aktualisieren. Die korrekte Verwaltung und Überwachung der robots.txt-Datei kann dazu beitragen, dass Suchmaschinen alle notwendigen Seiten crawlen können. Probieren Sie einfach den Adsbot robots.txt Checker aus, mit Funktionen die speziell für lokale SEO-Anforderungen optimiert sind, um zu sehen, wie er für Ihr Unternehmen funktioniert!

6. Häufige Fehler, Die Sie Beim Schreiben Ihrer Robots.txt-datei Vermeiden Sollten

Bei der Erstellung einer robots.txt-Datei sollten mehrere Fehler vermieden werden. Ein typischer Fehler ist die Verwendung einer falschen Syntax, die die Crawler der Suchmaschinen daran hindern könnte, die Seiten Ihrer Website zu sehen. Ein weiterer Fehler ist die Verwendung eines abschließenden Schrägstrichs beim Sperren oder Zulassen einer URL, was dazu führen kann, dass die Website nicht korrekt indiziert wird. Wichtig ist auch die korrekte Behandlung von 3xx-Statuscodes bei Umleitungen sowie das Erkennen von 4xx-Fehlern, die Crawling-Probleme verursachen können. Es ist wichtig zu wissen, dass das einfache Sperren einer Seite nur manchmal verhindert, dass Bots sie crawlen. Außerdem kann eine leere robots.txt-Datei zu Problemen beim Crawlen und Indexieren Ihrer Website führen. Es ist auch wichtig sicherzustellen, dass sich Ihre robots.txt-Datei im Stammverzeichnis Ihrer Website befindet. Mit dem Adsbot robots.txt-Checker können Sie sicher sein, dass Adsbot Ihre Website korrekt crawlt und indexiert. Indem Sie diese häufigen Fehler vermeiden und Ihre robots.txt-Datei regelmäßig testen und validieren, können Sie sicherstellen, dass Ihre Website von Suchmaschinen ordnungsgemäß gecrawlt und indiziert wird.

7. Wie Sie Bestimmte Benutzer-agenten Mit Robots.txt Zulassen Oder Blockieren

Um bestimmte Benutzer-Agenten mit robots.txt zuzulassen oder zu blockieren, müssen Website-Besitzer die Syntax der Datei verstehen. Jede Regel in der robots.txt-Datei blockiert oder erlaubt den Zugriff für alle oder einen bestimmten Crawler auf einen bestimmten Dateipfad auf der Domain oder Subdomain. Website-Besitzer können die „user-agent“-Direktive verwenden, um einen bestimmten Spider zu benennen und Regeln auf ihn anzuwenden. Bestimmte Regeln können auf bestimmte User-Agents angewandt werden, während anderen User-Agents das Crawlen der gesamten Website gestattet werden kann. Es ist wichtig zu beachten, dass Crawler die spezifischsten User-Agent-Regeln befolgen, die für sie mit dem in der „user-agent“-Direktive angegebenen Namen festgelegt wurden. Um sicherzustellen, dass bestimmte User-Agents ordnungsgemäß blockiert oder zugelassen werden, sollten Website-Besitzer das Adsbot robots.txt-Testtool verwenden. Dieses Tool funktioniert wie Googlebot und prüft, ob Ihre URL auf der Grundlage der in der robots.txt-Datei festgelegten User-Agent-Regeln ordnungsgemäß blockiert oder zugelassen wurde.

8. Wie Suchmaschinen Robots.txt Verwenden, Um Ihre Sitemap Zu Entdecken

In Abschnitt 8 des Blogs setzen wir die Untersuchung der Rolle der robots.txt-Datei bei der Suchmaschinenoptimierung von Websites fort. Diesmal geht es darum, wie Suchmaschinen diese Datei verwenden, um Ihre Sitemap zu finden. Eine Sitemap ist eine Datei, die alle Seiten, Bilder und anderen relevanten Inhalte Ihrer Website auflistet. Der Adsbot robots.txt checker zeigt Ihnen, wie Sie die robots.txt von Suchmaschinen auf Ihrer Website durch Crawling überprüfen können. Mit einer Sitemap erleichtern Sie es den Crawlern von Suchmaschinen, Ihre Seiten zu finden und zu indizieren. Dies gilt besonders für internationale Websites, wo mehrsprachige und geolokalisierte Inhalte präzise gesteuert werden müssen. Wenn Sie jedoch die Sitemap in Ihrer robots.txt-Datei blockieren, wissen die Suchmaschinen nicht, dass sie existiert. In diesem Abschnitt erfahren Sie, wie Sie Suchmaschinen-Crawlern den Zugriff auf die Sitemap in der robots.txt-Datei ermöglichen und warum dies für die Sichtbarkeit Ihrer Website wichtig ist. Wie immer bietet der Blog praktische Tipps und bewährte Verfahren für die Umsetzung dieser Strategie.

9. Wie Man Durch Robots.txt Blockierte Seiten Manuell Zur Indizierung Vorlegt

Nachdem Sie gesperrte Seiten in der Search Console identifiziert und eventuelle Fehler in der robots.txt-Datei mit Adsbot korrigiert haben, kann es erforderlich sein, diese Seiten manuell zur Indizierung anzumelden. Dies kann über das Tool zur URL-Überprüfung in der Search Console erfolgen. Wählen Sie zunächst die gesperrte URL aus und klicken Sie auf „Indizierung anfordern“, um die Crawling-Anforderung zu starten. Dieser Prozess kann mehrere Tage dauern, aber sobald die Seite indiziert ist, sollte sie in den Suchergebnissen erscheinen. Denken Sie daran, dass die wiederholte Übermittlung gesperrter Seiten zur Indizierung zu Einschränkungen durch Suchmaschinen führen kann. Daher ist es wichtig, sicherzustellen, dass die robots.txt-Datei korrekt konfiguriert ist, um unnötige Straßensperren für Webcrawler zu vermeiden. Besonders bei komplexen E-Commerce-Strukturen empfiehlt sich die E-Commerce-SEO-Checkliste als systematische Prüfhilfe. Wenn Sie die bewährten Verfahren zur Verwaltung und Überwachung der robots.txt-Datei mit dem Adsbot robots.txt-Checker befolgen, können Website-Besitzer ihre Website für Suchmaschinen optimieren und gleichzeitig die Kontrolle darüber behalten, wie Inhalte indiziert und für Benutzer angezeigt werden.

Popular Posts

-

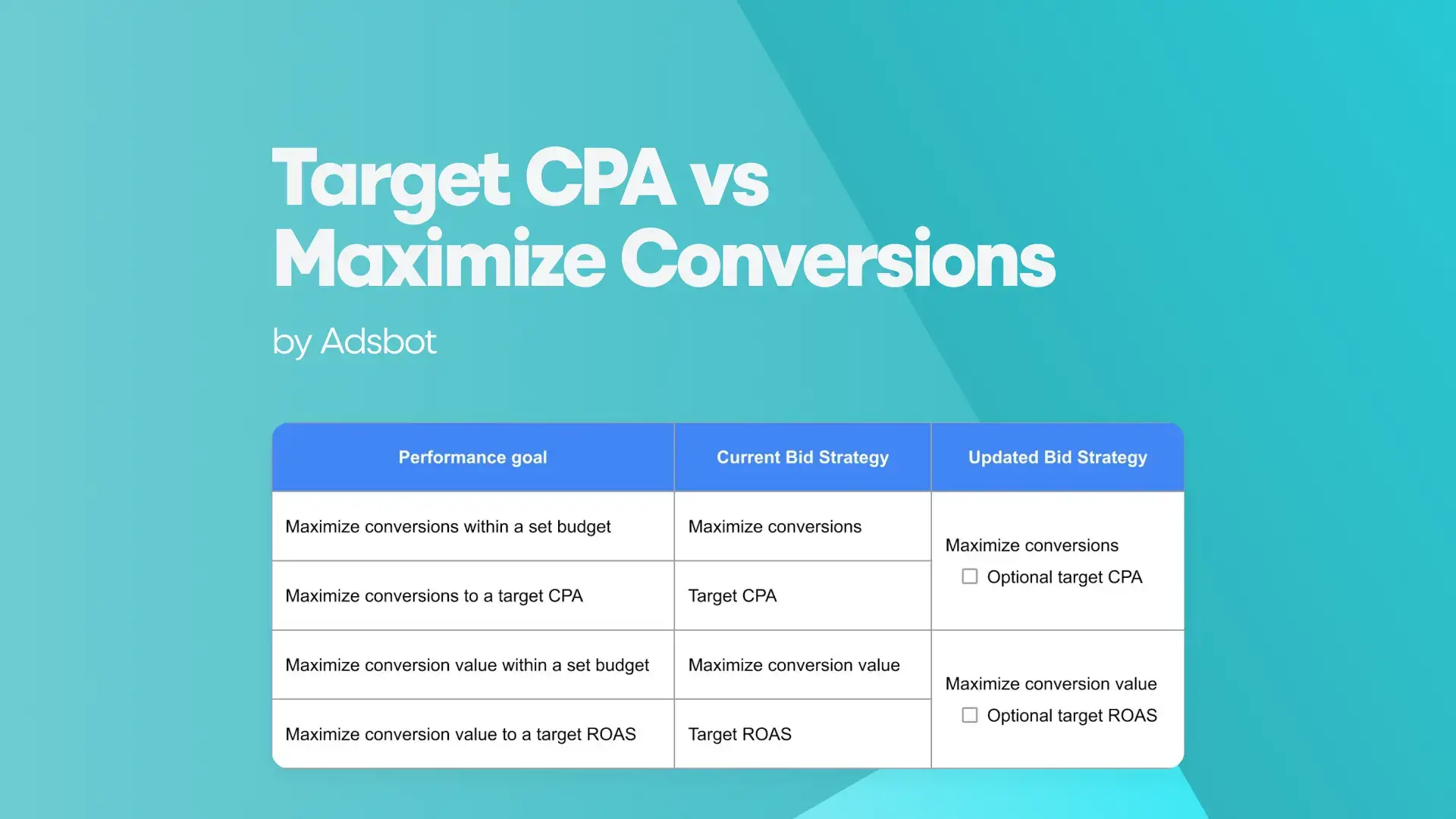

Ziel CPA vs. Conversions maximieren

Ziel Cpa Vs. Conversions Maximieren Um mit Google Ads den…

Read more -

Robots.txt-Prüfer

Wenn Sie eine Website betreiben, haben Sie wahrscheinlich schon von…

Read more -

Was ist der Anzeigenrang?

Was Ist Der Anzeigenrang? Der Anzeigenrang ist eine Metrik, die…

Read more -

Was ist der Conversion-Wert in Google Ads?

Was Ist Der Conversion-wert In Google Ads? Fragen Sie sich,…

Read more

Register for our Free 14-day Trial now!

No credit card required, cancel anytime.