Se você administra um site, provavelmente já ouviu falar sobre o arquivo robots.txt. Esse arquivo é fundamental porque ajuda os mecanismos de pesquisa a entender quais páginas podem ser rastreadas e indexadas em seu site. No entanto, pode ser confuso e desafiador editar e manter o arquivo robots.txt corretamente. É aqui que a ferramenta de verificação do robots.txt é útil! Nesta publicação do blog, discutiremos o que é um verificador de robots.txt, por que ele é essencial para o seu site e como você pode usá-lo com eficiência. Então, vamos começar!

1. A importância do Robots.txt para o SEO do seu site

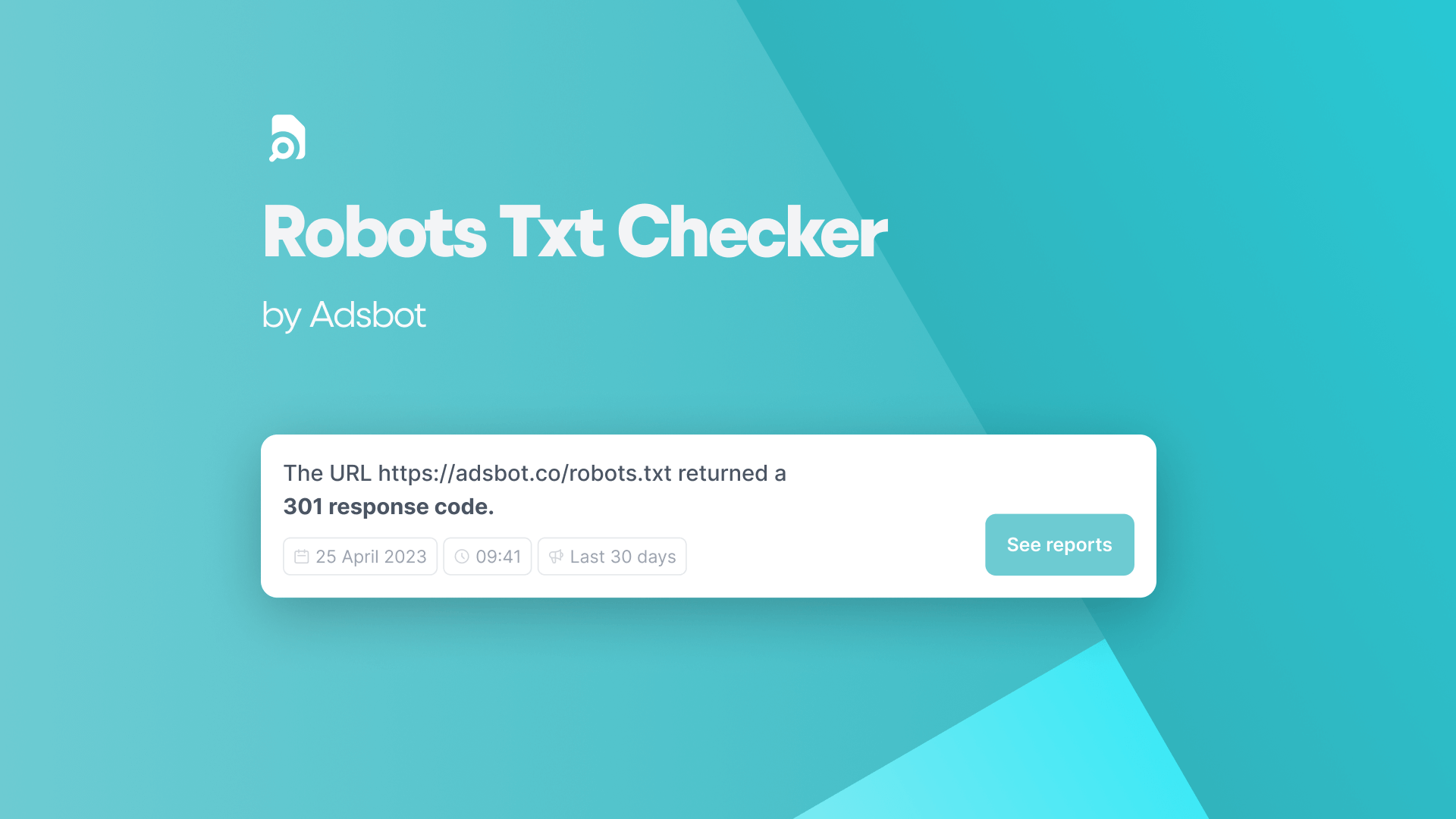

O arquivo robots.txt é um componente essencial de todo site, especialmente para SEO. Ao controlar quais páginas os rastreadores dos mecanismos de pesquisa podem acessar, os proprietários de sites podem proteger informações importantes e priorizar a indexação de páginas importantes. No entanto, se um site não tiver um arquivo robots.txt, o Google ainda poderá descobrir e indexar todas as páginas essenciais. Para estrategistas e desenvolvedores de SEO, o uso do testador de robots.txt do Adsbot pode ser uma ferramenta útil para gerenciar e entender como os spiders da Web rastreiam um site. Em geral, o arquivo robots.txt é um aspecto de SEO que não deve ser negligenciado. O Adsbot ajuda você a verificar o arquivo robots.txt, evitando assim a perda de tempo e dinheiro. Você pode perceber logo de início o que precisa fazer para ter anúncios bem otimizados.

2. Entendendo como os rastreadores da Web do Google usam o Robots.txt

Os rastreadores da Web do Google usam o arquivo robots.txt para determinar quais páginas do seu site podem ser rastreadas e indexadas. Ao especificar quais páginas bloquear ou permitir no arquivo robots.txt, você pode garantir que a visibilidade do seu site nos mecanismos de pesquisa permaneça otimizada. É importante entender que os bots dos mecanismos de pesquisa seguem as regras definidas no arquivo robots.txt, mas isso não garante que eles sempre as respeitarão. Além disso, se você acidentalmente bloquear páginas importantes, isso poderá afetar negativamente o SEO do seu site. É fundamental testar e validar regularmente seu arquivo robots.txt para garantir que ele esteja devidamente otimizado para a visibilidade do mecanismo de pesquisa. Com a ferramenta de verificação do robots.txt do Adsbot, você pode verificar o robots.txt na sua página para gerenciar e entender como os spiders da Web rastreiam um site. Seguindo as práticas recomendadas com a ferramenta de teste de robots.txt do Adsbot e evitando erros comuns ao escrever seu arquivo robots.txt, você pode gerenciar e monitorar com eficiência a acessibilidade do seu site aos rastreadores da Web.

3. Usando a ferramenta de teste do robots.txt para verificar URLs bloqueados

A ferramenta de teste do robots.txt do Adsbot é uma ferramenta essencial para os proprietários de sites que desejam garantir que bloquearam corretamente os URLs indesejados. Conforme discutido anteriormente, o arquivo robots.txt do Adsbot ajuda a gerenciar o tráfego de rastreadores para um site, e a ferramenta de teste do robots.txt permite que os webmasters verifiquem se o arquivo está bloqueando ou permitindo o acesso a URLs corretamente. Com a simples inserção de um URL bloqueado ou permitido na ferramenta de teste, os webmasters podem determinar rapidamente se o URL está acessível ou restrito. É importante validar o verificador de robots.txt do Adsbot regularmente para garantir que ele esteja funcionando corretamente e não cause problemas desnecessários de SEO. Entretanto, é igualmente importante ter cuidado ao bloquear URLs, pois o bloqueio excessivo de páginas importantes pode prejudicar o SEO de um site. É uma prática recomendada monitorar e ajustar consistentemente o testador de robots.txt do Adsbot para otimizar a capacidade de rastreamento do site e, ao mesmo tempo, evitar as possíveis armadilhas do bloqueio de páginas críticas.

4. Como testar e validar seu arquivo Robots.txt

Para garantir que o arquivo robots.txt do seu site esteja bloqueando bots indesejados e, ao mesmo tempo, permitindo que os mecanismos de busca rastreiem e indexem suas páginas, é essencial testá-lo e validá-lo regularmente. A ferramenta de teste do Adsbot robots.txt é uma ferramenta que permite inserir o URL do seu site e testar o arquivo robots.txt. O Adsbot verifica se há URLs e recursos bloqueados e ajuda você a identificar a regra que os está bloqueando. Ao identificar e corrigir esses problemas, você pode melhorar o SEO do seu site e evitar que os mecanismos de pesquisa indexem incorretamente o conteúdo. Recomenda-se testar e validar o arquivo robots.txt com o verificador do Adsbot após qualquer alteração significativa no seu site para garantir que ele continue a ter uma boa classificação nos resultados de pesquisa.

5. Os riscos de bloquear páginas importantes com o Robots.txt

O bloqueio de páginas importantes com um arquivo robots.txt pode trazer riscos significativos para o SEO de um site. Embora um URL não permitido ainda possa aparecer nos resultados de pesquisa, ele não terá uma descrição, o que pode afetar negativamente as taxas de cliques. Além disso, a não permissão de URLs significa que o Google não pode rastrear essas páginas para determinar seu conteúdo, o que pode fazer com que elas saiam dos resultados de pesquisa. É importante não desautorizar acidentalmente páginas importantes, pois isso pode afetar significativamente o tráfego e a visibilidade de seu website. Portanto, é fundamental entender como verificar e validar corretamente seu arquivo robots.txt e evitar erros comuns ao redigi-lo. O Adsbot é um software de otimização de PPC que também inclui um serviço de teste de robots.txt. Graças à tecnologia perfeita de aprendizado de máquina, o Adsbot ajuda sua conta a ser bem analisada, aprimorada e atualizada de acordo com as necessidades do cliente em tempo real. O gerenciamento e o monitoramento adequados do arquivo robots.txt podem ajudar a garantir que os mecanismos de pesquisa possam rastrear todas as páginas necessárias. Você pode experimentar facilmente o verificador de robots.txt do Adsbot para ver como ele funciona para sua empresa!

6. Erros comuns a serem evitados ao escrever seu arquivo Robots.txt

Vários erros devem ser evitados ao criar um arquivo robots.txt. Um erro típico é a utilização de sintaxe incorreta, o que pode impedir que os rastreadores dos mecanismos de pesquisa vejam as páginas do seu site. Outro erro é usar uma barra final ao bloquear ou permitir um URL, o que pode fazer com que o site não seja indexado corretamente. É importante observar que, às vezes, a simples proibição de uma página apenas impede que os bots a rastreiem. Além disso, ter um arquivo robots.txt vazio pode causar problemas com o rastreamento e a indexação do seu site. Também é importante garantir que o arquivo robots.txt esteja no diretório raiz do seu site. Quando você tem a ferramenta de verificação do robots.txt do Adsbot, pode ter certeza de que o Adsbot rastreia e indexa corretamente o seu site. Evitando esses erros comuns e testando e validando regularmente seu arquivo robots.txt, você pode garantir que seu site seja rastreado e indexado adequadamente pelos mecanismos de busca.

7. Como permitir ou bloquear agentes de usuário específicos com o Robots.txt

Para permitir ou bloquear agentes de usuários específicos com o robots.txt, os proprietários de sites precisam entender a sintaxe do arquivo. Cada regra no arquivo robots.txt bloqueia ou permite o acesso de todos ou de um rastreador específico a um caminho de arquivo especificado no domínio ou subdomínio. Os proprietários de sites podem usar a diretiva “user-agent” para nomear um spider específico e aplicar regras a ele. Regras específicas podem ser aplicadas a determinados agentes de usuário, enquanto outros agentes de usuário podem ter permissão para rastrear o site inteiro. É importante observar que os rastreadores seguirão as regras de agente de usuário mais específicas definidas para eles com o nome especificado na diretiva “user-agent”. Para garantir o bloqueio ou a permissão adequada de agentes de usuário específicos, os proprietários de sites devem usar a ferramenta de teste Adsbot robots.txt. Essa ferramenta funciona como o Googlebot e valida se o seu URL foi bloqueado ou permitido corretamente com base nas regras de agente de usuário definidas no arquivo robots.txt.

8. Como os mecanismos de pesquisa usam o Robots.txt para descobrir seu Sitemap

Na seção 8 do blog, continuamos a explorar a função do arquivo robots.txt no SEO do site. Desta vez, o foco está em como os mecanismos de pesquisa usam esse arquivo para descobrir o mapa do site. Para quem não está familiarizado, um mapa do site é um arquivo que lista todas as páginas, imagens e outros conteúdos relevantes do seu site. O verificador de robots.txt do Adsbot mostra como verificar o robots.txt dos mecanismos de pesquisa para o seu site por meio de rastreamento. Com um mapa do site, fica mais fácil para os rastreadores dos mecanismos de busca encontrarem e indexarem suas páginas. No entanto, se você bloquear o mapa do site em seu arquivo robots.txt, os mecanismos de pesquisa não saberão que ele existe. Nesta seção, os leitores aprenderão como permitir que os rastreadores dos mecanismos de pesquisa acessem o mapa do site no robots.txt e por que isso é importante para a visibilidade do site. Como sempre, o blog oferece dicas práticas e práticas recomendadas para implementar essa estratégia.

9. Como enviar manualmente páginas bloqueadas pelo Robots.txt para indexação

Depois de identificar as páginas bloqueadas no Search Console e corrigir os erros no arquivo robots.txt com o Adsbot, pode ser necessário enviar manualmente essas páginas para indexação. Isso pode ser feito por meio da ferramenta de inspeção de URL no Search Console. Primeiro, selecione o URL bloqueado e clique em “Request Indexing” (Solicitar indexação) para iniciar a solicitação de rastreamento. Esse processo pode levar vários dias para ser concluído, mas assim que a página for indexada, ela deverá aparecer nos resultados de pesquisa. Lembre-se de que o envio repetido de páginas bloqueadas para indexação pode resultar em limitações impostas pelos mecanismos de busca, portanto, é importante garantir que o arquivo robots.txt esteja configurado corretamente para evitar bloqueios desnecessários para os rastreadores da Web. Ao seguir as práticas recomendadas com o verificador de robots.txt do Adsbot para gerenciar e monitorar o arquivo robots.txt, os proprietários de sites podem otimizar o site para os mecanismos de pesquisa e, ao mesmo tempo, manter o controle sobre como o conteúdo é indexado e exibido para os usuários.

Popular Posts

-

Alvo CPA vs. Maximizar conversões

Para obter o máximo de sucesso com o Google Ads,…

Read more -

Verificador Robots.txt

Se você administra um site, provavelmente já ouviu falar sobre…

Read more -

O que é o Ad Rank?

A classificação de anúncios é uma métrica usada pelo Google…

Read more -

Como aumentar a CTR esperada no Google Ads

O Google Ads evoluiu e se tornou uma ferramenta essencial…

Read more

Register for our Free 14-day Trial now!

No credit card required, cancel anytime.