Als je een website beheert, heb je waarschijnlijk wel eens gehoord over het robots.txt-bestand. Dit bestand is cruciaal omdat het zoekmachines helpt te begrijpen welke pagina’s ze mogen crawlen en indexeren op uw website. Het kan echter verwarrend en lastig zijn om het robots.txt-bestand correct te bewerken en te onderhouden. Dit is waar de robots.txt checker van pas komt! In deze blogpost bespreken we wat een robots.txt checker is, waarom het essentieel is voor je website en hoe je het effectief kunt gebruiken. Dus laten we beginnen!

1. Het belang van Robots.txt voor de SEO van je website

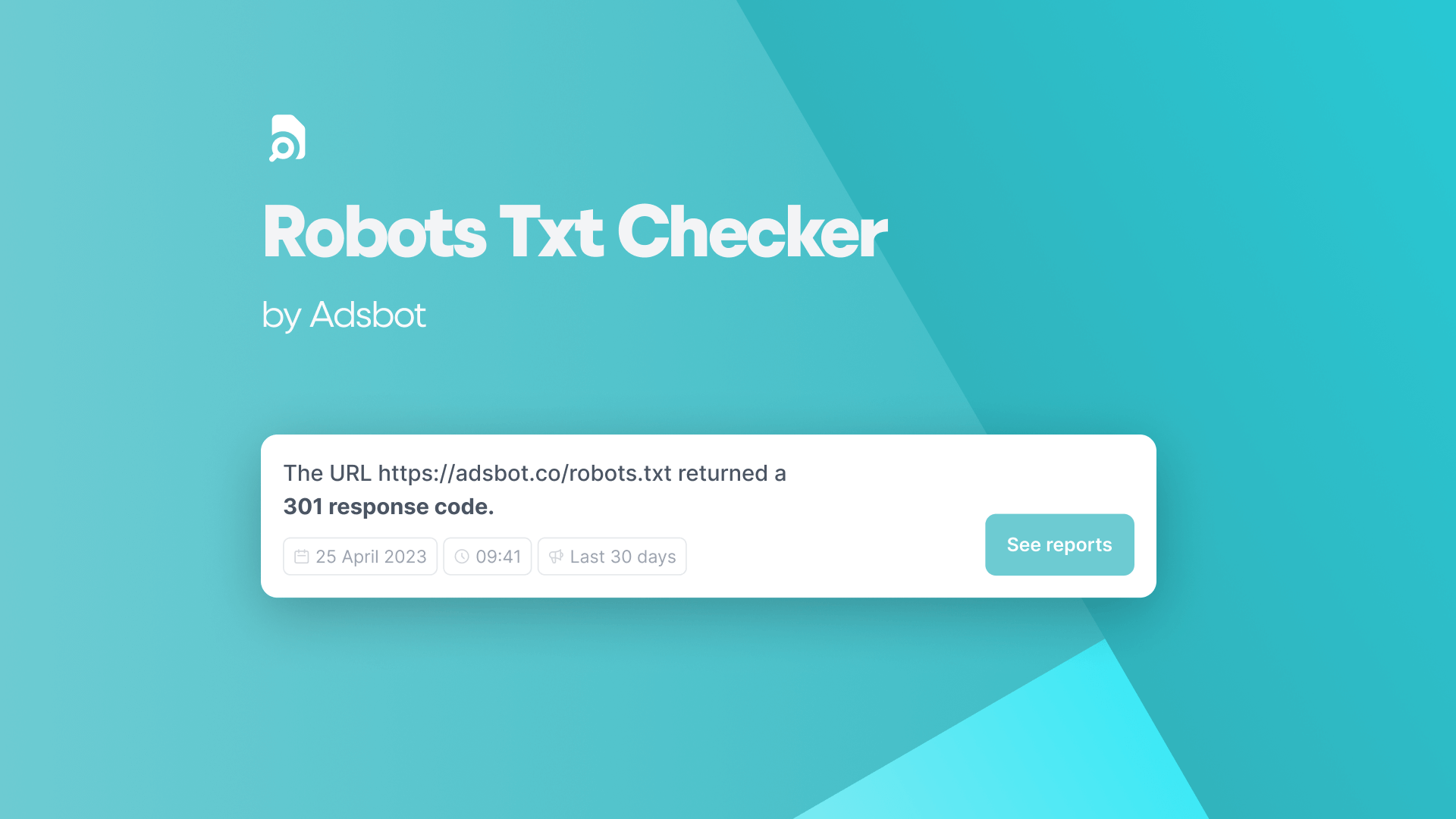

Het robots.txt-bestand is een essentieel onderdeel van elke website, vooral voor SEO. Door te bepalen welke pagina’s toegankelijk zijn voor crawlers van zoekmachines, kunnen website-eigenaren belangrijke informatie veiligstellen en prioriteit geven aan het indexeren van belangrijke pagina’s. Als een website echter geen robots.txt-bestand heeft, kan Google meestal nog steeds alle essentiële pagina’s ontdekken en indexeren. Voor SEO strategen en ontwikkelaars kan het gebruik van de Adsbot robots.txt tester een nuttig hulpmiddel zijn bij het beheren en begrijpen hoe webspiders een website crawlen. Over het algemeen is het robots.txt-bestand een aspect van SEO dat niet over het hoofd mag worden gezien. Adsbot helpt je hoe je robots.txt kunt controleren, waardoor je tijd- en geldverspilling kunt voorkomen. Je merkt al snel wat je moet doen voor goed geoptimaliseerde advertenties.

2. Begrijpen hoe Google-webcrawlers Robots.txt gebruiken

Webcrawlers van Google gebruiken robots.txt om te bepalen welke pagina’s van uw website ze mogen crawlen en indexeren. Door in uw robots.txt-bestand aan te geven welke pagina’s u wilt blokkeren of toestaan, kunt u ervoor zorgen dat de zichtbaarheid van uw website in zoekmachines geoptimaliseerd blijft. Het is belangrijk om te begrijpen dat de bots van zoekmachines de regels in uw robots.txt-bestand volgen, maar het is geen garantie dat ze zich er altijd aan houden. Bovendien, als je per ongeluk belangrijke pagina’s blokkeert, kan dit een negatieve invloed hebben op de SEO van je website. Het is cruciaal om uw robots.txt-bestand regelmatig te testen en te valideren om ervoor te zorgen dat het goed is geoptimaliseerd voor de zichtbaarheid in zoekmachines. Met de Adsbot robots.txt checker tool kunt u robots.txt op uw pagina controleren om te beheren en te begrijpen hoe webspiders een website crawlen. Door best practices te volgen met de Adsbot robots.txt-testtool en veelgemaakte fouten bij het schrijven van uw robots.txt-bestand te vermijden, kunt u de toegankelijkheid van uw website voor webcrawlers effectief beheren en bewaken.

3. De Robots.txt-testtool gebruiken om geblokkeerde URL’s te controleren

De Adsbot robots.txt-testtool is een essentieel hulpmiddel voor website-eigenaren die er zeker van willen zijn dat ze ongewenste URL’s goed hebben geblokkeerd. Zoals eerder besproken, helpt het Adsbot robots.txt-bestand het crawlerverkeer naar een website te beheren en met de robots.txt-testtool kunnen webmasters controleren of het bestand de toegang tot URL’s correct blokkeert of toestaat. Door simpelweg een geblokkeerde of toegestane URL in het testprogramma in te voeren, kunnen webmasters snel bepalen of de URL toegankelijk is of niet. Het is belangrijk om de Adsbot robots.txt-checker regelmatig te valideren om ervoor te zorgen dat deze correct werkt en geen onnodige SEO-problemen veroorzaakt. Het is echter net zo belangrijk om voorzichtig te zijn met het blokkeren van URL’s, omdat het overmatig blokkeren van belangrijke pagina’s de SEO van een website kan schaden. Het is het beste om de Adsbot robots.txt tester consequent te controleren en aan te passen om de crawlability van de website te optimaliseren en tegelijkertijd de potentiële valkuilen van het blokkeren van kritieke pagina’s te vermijden.

4. Hoe uw robots.txt-bestand te testen en te valideren

Om ervoor te zorgen dat het robots.txt-bestand van uw website ongewenste bots blokkeert terwijl zoekmachines uw pagina’s kunnen crawlen en indexeren, is het essentieel om het regelmatig te testen en te valideren. Adsbot robots.txt testing tool is een tool waarmee u de URL van uw website kunt invoeren en het robots.txt-bestand kunt testen. Adsbot controleert op geblokkeerde URL’s en bronnen en helpt je de regel te identificeren die deze blokkeert. Door deze problemen te identificeren en op te lossen, kunt u de SEO van uw website verbeteren en voorkomen dat zoekmachines inhoud onjuist indexeren. Het wordt aanbevolen om uw robots.txt-bestand te testen en te valideren met Adsbot checker na elke belangrijke wijziging aan uw website om ervoor te zorgen dat uw website goed blijft scoren in de zoekresultaten.

5. De risico’s van het blokkeren van belangrijke pagina’s met Robots.txt

Het blokkeren van belangrijke pagina’s met een robots.txt-bestand kan aanzienlijke risico’s hebben voor de SEO van een website. Hoewel een niet-toegelaten URL nog steeds kan worden weergegeven in de zoekresultaten, heeft deze geen beschrijving, wat een negatieve invloed kan hebben op de doorklikratio. Daarnaast betekent het niet toestaan van URL’s dat Google deze pagina’s niet kan crawlen om de inhoud te bepalen, waardoor ze uit de zoekresultaten kunnen verdwijnen. Het is belangrijk om niet per ongeluk belangrijke pagina’s niet toe te staan, omdat dit het verkeer en de zichtbaarheid van je website aanzienlijk kan beïnvloeden. Daarom is het cruciaal om te begrijpen hoe u uw robots.txt-bestand goed controleert en valideert en veelgemaakte fouten bij het schrijven ervan vermijdt. Adsbot is een PPC-optimalisatiesoftware die ook een robots.txt-testservice bevat. Dankzij de perfecte machine learning-technologie helpt Adsbot uw account goed te analyseren, te verbeteren en bij te werken op basis van real-time klantbehoeften. Goed beheer en controle van het robots.txt-bestand kan ervoor zorgen dat zoekmachines alle benodigde pagina’s kunnen crawlen. Je kunt Adsbot robots.txt checker eenvoudig uitproberen om te zien hoe het voor jouw bedrijf werkt!

6. Veelvoorkomende fouten die u moet vermijden bij het schrijven van uw Robots.txt-bestand

Bij het maken van een robots.txt-bestand moeten verschillende fouten worden vermeden. Een typische fout is het gebruik van onjuiste syntaxis, waardoor zoekmachinecrawlers de pagina’s van uw site niet kunnen zien. Een andere fout is het gebruik van een slash bij het blokkeren of toestaan van een URL, waardoor de website mogelijk niet correct wordt geïndexeerd. Het is belangrijk om op te merken dat het simpelweg niet toestaan van een pagina er slechts soms voor zorgt dat bots de pagina niet kunnen crawlen. Daarnaast kan een leeg robots.txt-bestand problemen veroorzaken met het crawlen en indexeren van uw site. Het is ook belangrijk om ervoor te zorgen dat uw robots.txt-bestand in de hoofdmap van uw site staat. Met de Adsbot robots.txt checker kunt u er zeker van zijn dat Adsbot uw website op de juiste manier crawlt en indexeert. Door deze veelgemaakte fouten te vermijden en uw robots.txt-bestand regelmatig te testen en te valideren, kunt u ervoor zorgen dat uw site goed wordt gecrawld en geïndexeerd door zoekmachines.

7. Hoe specifieke gebruikersagenten toe te staan of te blokkeren met Robots.txt

Om specifieke gebruikersagenten toe te staan of te blokkeren met robots.txt, moeten website-eigenaren de syntaxis van het bestand begrijpen. Elke regel in het robots.txt-bestand blokkeert of staat de toegang toe voor alle of een specifieke crawler tot een opgegeven bestandspad op het domein of subdomein. Website-eigenaren kunnen de richtlijn “user-agent” gebruiken om een specifieke spider te benoemen en er regels op toe te passen. Specifieke regels kunnen worden toegepast op bepaalde user-agents, terwijl andere user-agents de hele site mogen crawlen. Het is belangrijk om op te merken dat crawlers de meest specifieke user-agent regels zullen volgen die voor hen zijn ingesteld met de naam die is opgegeven in de “user-agent” directive. Om ervoor te zorgen dat specifieke user-agents op de juiste manier worden geblokkeerd of toegestaan, moeten website-eigenaren de Adsbot robots.txt-testtool gebruiken. Deze tool werkt net als Googlebot en valideert of uw URL correct is geblokkeerd of toegestaan op basis van de regels voor gebruikersagenten die zijn ingesteld in het robots.txt-bestand.

8. Hoe zoekmachines Robots.txt gebruiken om uw sitemap te ontdekken

In deel 8 van deze blog gaan we verder met het verkennen van de rol van het robots.txt bestand in website SEO. Deze keer ligt de focus op hoe zoekmachines dit bestand gebruiken om je sitemap te ontdekken. Voor degenen die het niet weten: een sitemap is een bestand met alle pagina’s, afbeeldingen en andere relevante inhoud op je website. Adsbot robots.txt checker laat zien hoe je robots.txt van zoekmachines kunt controleren op je website door te crawlen. Met een sitemap maak je het de crawlers van zoekmachines gemakkelijker om je pagina’s te vinden en te indexeren. Als u de sitemap echter blokkeert in uw robots.txt-bestand, weten zoekmachines niet dat deze bestaat. In dit gedeelte leren lezers hoe ze zoekmachine crawlers toegang kunnen geven tot de sitemap in robots.txt en waarom dit belangrijk is voor de zichtbaarheid van de website. Zoals altijd biedt de blog praktische tips en best practices voor het implementeren van deze strategie.

9. Hoe handmatig door Robots.txt geblokkeerde pagina’s indienen voor indexering

Na het identificeren van geblokkeerde pagina’s in Search Console en het corrigeren van eventuele fouten in het robots.txt-bestand met Adsbot, kan het nodig zijn om deze pagina’s handmatig in te dienen voor indexering. Dit kan worden gedaan via de URL-inspectietool in Search Console. Selecteer eerst de geblokkeerde URL en klik op “Indexering aanvragen” om het crawlverzoek te starten. Het kan enkele dagen duren voordat dit proces is voltooid, maar zodra de pagina is geïndexeerd, zou deze in de zoekresultaten moeten verschijnen. Houd er rekening mee dat het herhaaldelijk indienen van geblokkeerde pagina’s voor indexering kan leiden tot beperkingen opgelegd door zoekmachines, dus het is belangrijk om ervoor te zorgen dat het robots.txt-bestand correct is geconfigureerd om onnodige wegversperringen voor webcrawlers te voorkomen. Door de best practices te volgen met Adsbot robots.txt checker voor het beheren en controleren van het robots.txt-bestand, kunnen website-eigenaren hun site optimaliseren voor zoekmachines en toch controle houden over hoe inhoud wordt geïndexeerd en weergegeven aan gebruikers.

Popular Posts

-

Robots.txt-controleur

Robots.txt-controleurAls je een website beheert, heb je waarschijnlijk wel eens…

Read more -

CPA targeten vs conversies maximaliseren

Om maximale triomf te behalen met Google Ads, is het…

Read more -

Wat is advertentieranglijst?

Ad Rank is een metriek die door Google Ads wordt…

Read more -

Wat is bieden op merken in Google Ads?

Bent u een adverteerder die het meeste uit uw Google…

Read more

Register for our Free 14-day Trial now!

No credit card required, cancel anytime.